| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 | 31 |

- Docker

- nvidia-smi

- 프로그래머스

- 오류

- C

- mysql

- 핑거스타일

- VS Code

- Linux

- error

- C#

- Visual Studio

- OpenCV

- 기타 연주

- pandas

- label

- windows forms

- Python

- Numpy

- 채보

- ubuntu

- JSON

- SSH

- pytorch

- YOLO

- paramiko

- Selenium

- C++

- pip

- 컨테이너

- Today

- Total

목록nvidia-smi (4)

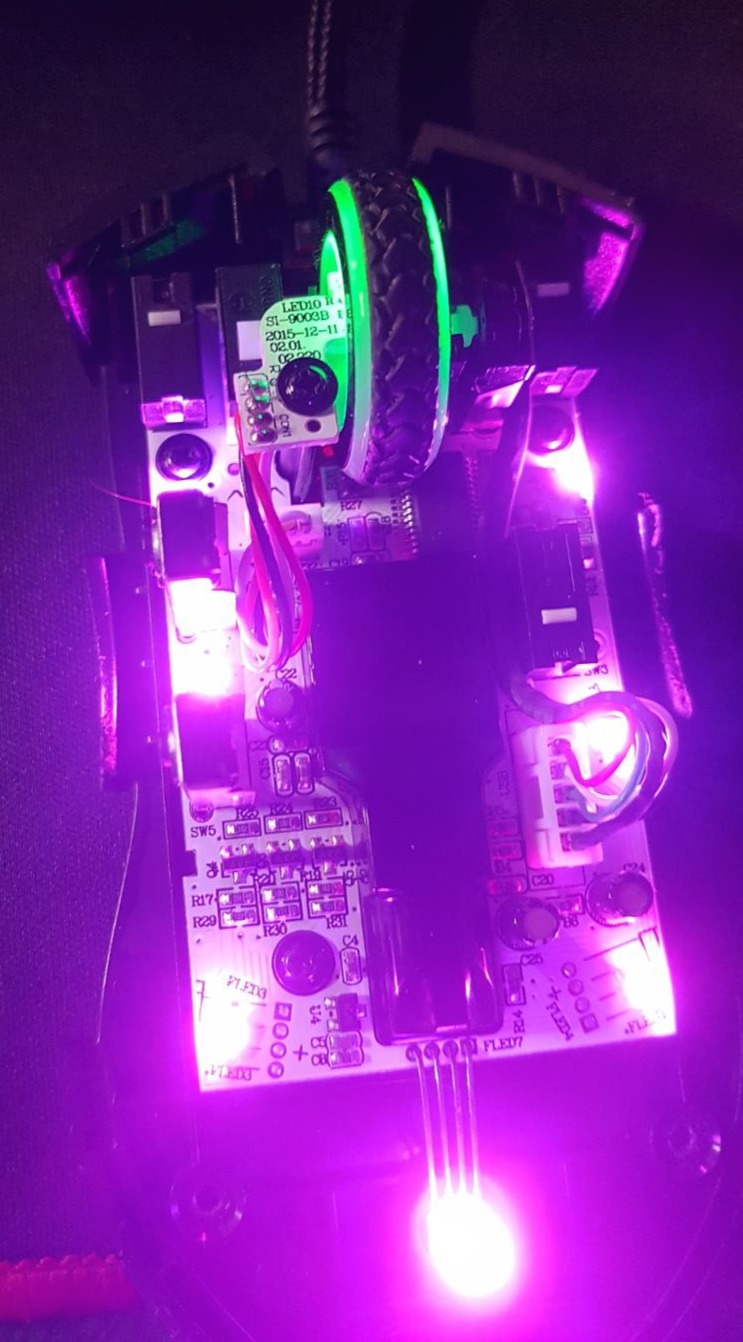

기계는 거짓말하지 않는다

Kubernetes Pod Docker 컨테이너 내에서 nvidia-smi Failed to initialize NVML: Unknown Error Kubernetes Pod Docker 컨테이너 내에서 nvidia-smi Failed to initialize NVML: Unknown Error쿠버네티스 파드의 도커 컨테이너 내에서 nvidia-smi를 입력했을 때, 간혹 아래의 오류를 보는 경우가 있다.Failed to initialize NVML: Unknown Error컨테이너를 정지했다가 재시작하면 동작하긴 하지만 근본machine-does-not-lie.tistory.com이 글에 이은 정보이다.Docker 컨테이너 내에서 nvidia-smi를 입력했을 때, 간혹 아래의 오류를 보는 경우가 있다..

쿠버네티스 파드의 도커 컨테이너 내에서 nvidia-smi를 입력했을 때, 간혹 아래의 오류를 보는 경우가 있다.Failed to initialize NVML: Unknown Error컨테이너를 정지했다가 재시작하면 동작하긴 하지만 근본적인 해결법이 아니다.오랫동안 많은 고민을 했지만 다른 방법으로도 해결하진 못했다./etc/nvidia-container-runtime/config.toml에서 no-cgroups = false를 설정하거나,/etc/docker/daemon.json에서 "exec-opts": ["native.cgroupdriver=cgroupfs"] 추가 등으로도 해결되지 않았다. 해결법은 Deployment의 yaml 설정 파일에서 privileged를 true로 설정하거나(권장하지 않..

Ubuntu에서 그래픽카드를 확인할 때 간단하게 사용할 수 있는 명령어이다.lspci | grep -i VGAsudo lshw -C display NVIDIA 그래픽카드와 드라이버가 설치되어 있다면 nvidia-smi 명령어를 사용하면 된다.nvidia-smi

nvidia-smi 명령어를 이용하여 그래픽카드 정보와 사용량을 알려고 할 때, 몇 초 느리게 출력되면서, GPU 사용량이 높게 출력되는 것을 볼 때가 있다. GPU persistence 모드라는 것이 있는데, 이 모드가 아닐 경우 GPU가 유휴 상태에 있다가 깨어나면서 오래 걸리는 것이고 순간적으로 GPU 사용량이 증가한다. nvidia-smi --help | grep persistence 위 명령어를 입력해서 보면 persistence mode라는것이 확인 된다. sudo nvidia-smi -pm 1 위 명령어를 이용하여 persistence mode를 사용하도록 만든다. 다시 nvidia-smi를 입력해 보면 빠르게 출력되는 것을 볼 수 있다. nvidia-smi is slow on Ubuntu ..