| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- nvidia-smi

- 오류

- pandas

- error

- 기타 연주

- 핑거스타일

- Linux

- 프로그래머스

- YOLO

- JSON

- Python

- C#

- C++

- C

- Selenium

- label

- SSH

- 컨테이너

- ubuntu

- pytorch

- 채보

- Docker

- windows forms

- OpenCV

- Numpy

- VS Code

- Visual Studio

- mysql

- pip

- paramiko

- Today

- Total

기계는 거짓말하지 않는다

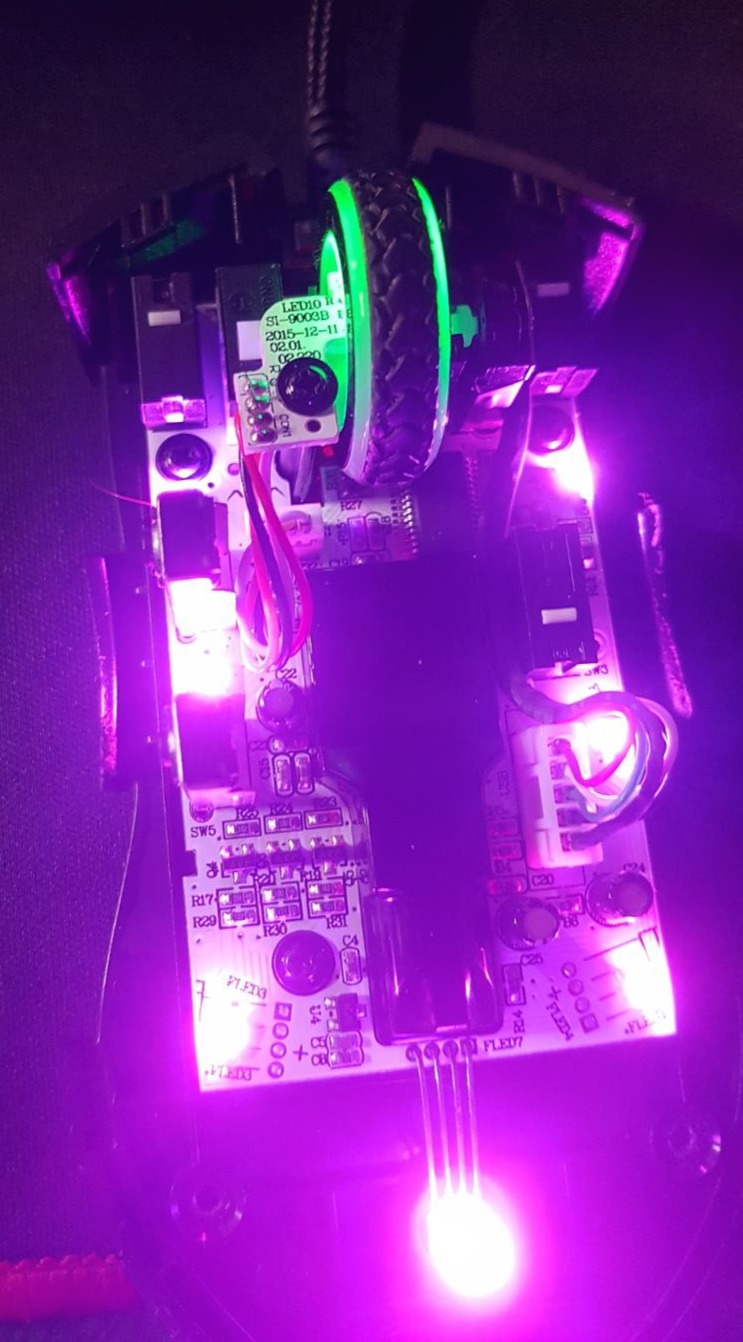

Docker 컨테이너 내에서 nvidia-smi Failed to initialize NVML: Unknown Error 본문

Docker 컨테이너 내에서 nvidia-smi Failed to initialize NVML: Unknown Error

KillinTime 2025. 2. 14. 19:11Kubernetes Pod Docker 컨테이너 내에서 nvidia-smi Failed to initialize NVML: Unknown Error

Kubernetes Pod Docker 컨테이너 내에서 nvidia-smi Failed to initialize NVML: Unknown Error

쿠버네티스 파드의 도커 컨테이너 내에서 nvidia-smi를 입력했을 때, 간혹 아래의 오류를 보는 경우가 있다.Failed to initialize NVML: Unknown Error컨테이너를 정지했다가 재시작하면 동작하긴 하지만 근본

machine-does-not-lie.tistory.com

이 글에 이은 정보이다.

Docker 컨테이너 내에서 nvidia-smi를 입력했을 때, 간혹 아래의 오류를 보는 경우가 있다.

Failed to initialize NVML: Unknown Error컨테이너를 정지했다가 재시작하는 방법과 Linux Capabilities를 사용하는 방법이 아닌 장치를 추가하는 방법이다.

Linux Capabilities도 CAP_SYS_ADMIN은 권장하지 않는다. root와 거의 동일한 권한을 가질 수 있기 때문이다.

특수한 경우에는 capabilities가 필요할 수 있겠지만, 일반적인 GPU 사용에서는

대신 컨테이너 시작(run) 시 다음 명령어로 장치를 등록할 수 있다.

--device=/dev/{device_name}장치들은 밑의 명령어로 확인할 수 있다.

ls /dev이때, NVIDIA GPU 관련 장치를 docker run 시에 추가해 준다.

--device=/dev/nvidia0 \ --device=/dev/nvidiactl \ --device=/dev/nvidia-uvm \ --device=/dev/nvidia-uvm-tools

/dev/nvidia0: 첫 번째 GPU 장치

/dev/nvidiactl: NVIDIA 드라이버 제어 인터페이스

/dev/nvidia-uvm: Unified Video Memory (UVM), CUDA의 가상 메모리 관련

/dev/nvidia-uvm-tools: UVM 관련 도구

위 방법도 기간이 길지 않지만 2주 정도 테스트 시 문제가 다시 발생하지 않았다.

'Container Tools > Docker' 카테고리의 다른 글

| Ubuntu Docker 이미지 저장 위치 변경 (0) | 2024.08.27 |

|---|---|

| Docker 컨테이너 내부 한글 locale UTF-8 환경 변수 설정 (0) | 2024.07.14 |

| Ubuntu Docker daemon 기본 runtime nvidia 변경 (0) | 2024.03.22 |

| Docker 이미지 레이어(layer) 병합(Merge), 이미지 압축 (2) | 2024.02.29 |

| 빈 도커 이미지(empty docker image) 생성 (0) | 2024.02.25 |