Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

Tags

- JSON

- C

- error

- Python

- pandas

- LIST

- pytorch

- VS Code

- windows forms

- Numpy

- pip

- SSH

- C#

- paramiko

- mysql

- Visual Studio

- ubuntu

- 핑거스타일

- OpenCV

- YOLO

- Docker

- 오류

- label

- C++

- Selenium

- Linux

- 프로그래머스

- 컨테이너

- 채보

- 기타 연주

Archives

- Today

- Total

기계는 거짓말하지 않는다

활성화 함수(Activation Function) 본문

입력 신호의 합을 출력 신호로 변환하는 함수를 활성화 함수(Activation Function)라 한다.

임곗값을 경계로 출력 신호가 바뀐다. 신경망에서는 선형 함수일 경우 신경망의 층을 깊게 하는 의미가 없어진다.

미분하였을 때 항상 동일한 gradient가 나오게 된다. 따라서 비선형 함수를 사용한다.

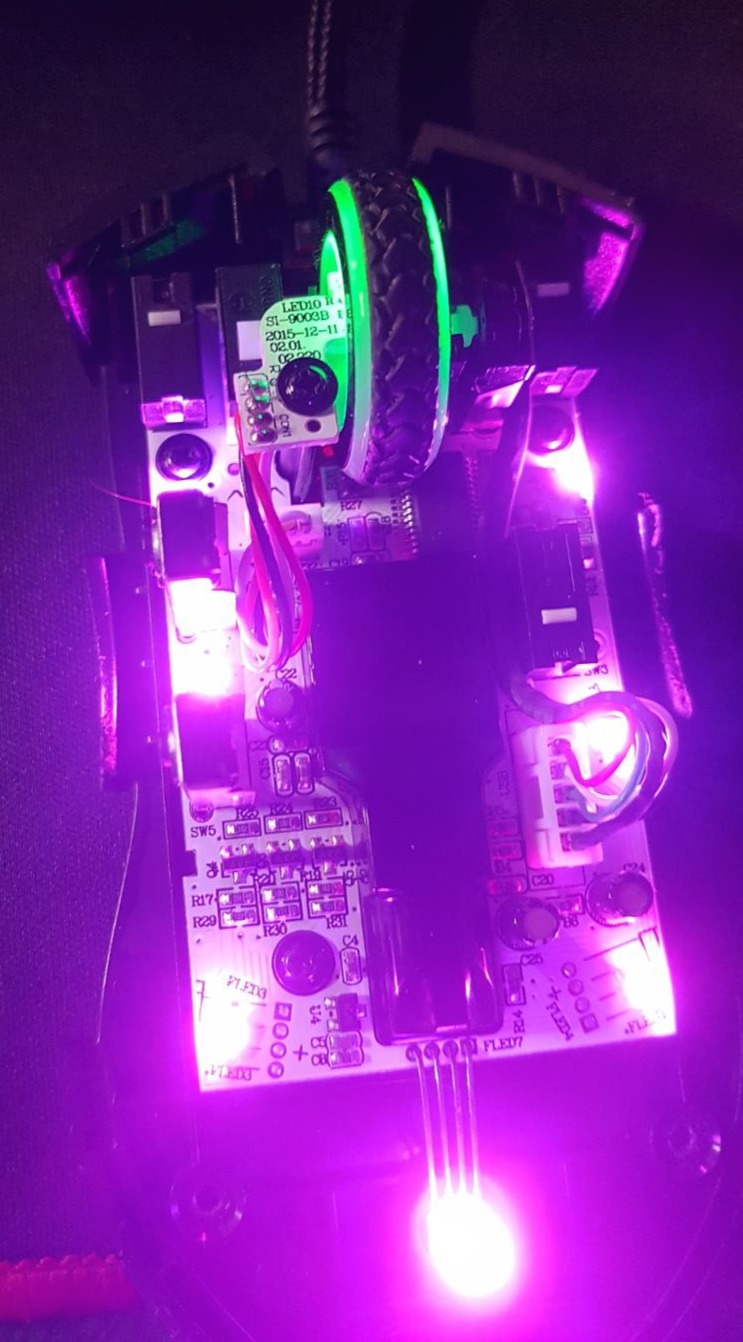

Step Function

입력이 0 초과일 경우 1, 그 외 0

import numpy as np

import matplotlib.pyplot as plt

def step_function(x : np):

return (x > 0).astype(np.int64)

x = np.arange(-5.0, 5.0, 0.1)

y = step_function(x)

plt.plot(x, y)

plt.plot([0, 0], [1.0, 0.0], color="r", linestyle="--") # center line

plt.title("Step Function")

plt.ylim(-0.1, 1.1) # y축 범위

plt.show()

Sigmoid

0~1사이 값을 반환하는 S자 모양 곡선 함수

h(x) = 1 / (1 + e^-x)

import numpy as np

import matplotlib.pyplot as plt

def sigmoid(x):

return 1 / (1 + np.exp(-x))

x = np.arange(-5.0, 5.0, 0.1)

y = sigmoid(x)

plt.plot(x, y)

plt.plot([0, 0], [1.0, 0.0], color="r", linestyle="--") # center line

plt.title("Sigmoid")

plt.ylim(-0.1, 1.1) # y축 범위

plt.show()

ReLU(Rectified Linear Unit)

0 초과일 경우 그대로 출력, 0 이하이면 0

import numpy as np

import matplotlib.pyplot as plt

def relu(x):

return np.maximum(0, x)

x = np.arange(-5.0, 5.0, 0.1)

y = relu(x)

plt.plot(x, y)

plt.plot([0, 0], [5.0, -0.2], color="r", linestyle="--") # center line

plt.title("ReLU")

plt.xlim(-6.0, 6.0) # x축 범위

plt.ylim(-0.5, 5.5) # y축 범위

plt.show()

'AI' 카테고리의 다른 글

| YOLOv3 deepSORT KeyError: "The name 'net/images:0' (0) | 2022.07.01 |

|---|---|

| min, max 좌표 YOLO label format 변환 (0) | 2022.05.27 |

| 다층 퍼셉트론(Multi-Layer Perceptron) XOR (0) | 2021.10.18 |

| Pytorch Multiclass Classification (0) | 2021.10.11 |

| Pytorch torchvision transforms (0) | 2021.09.05 |

Comments